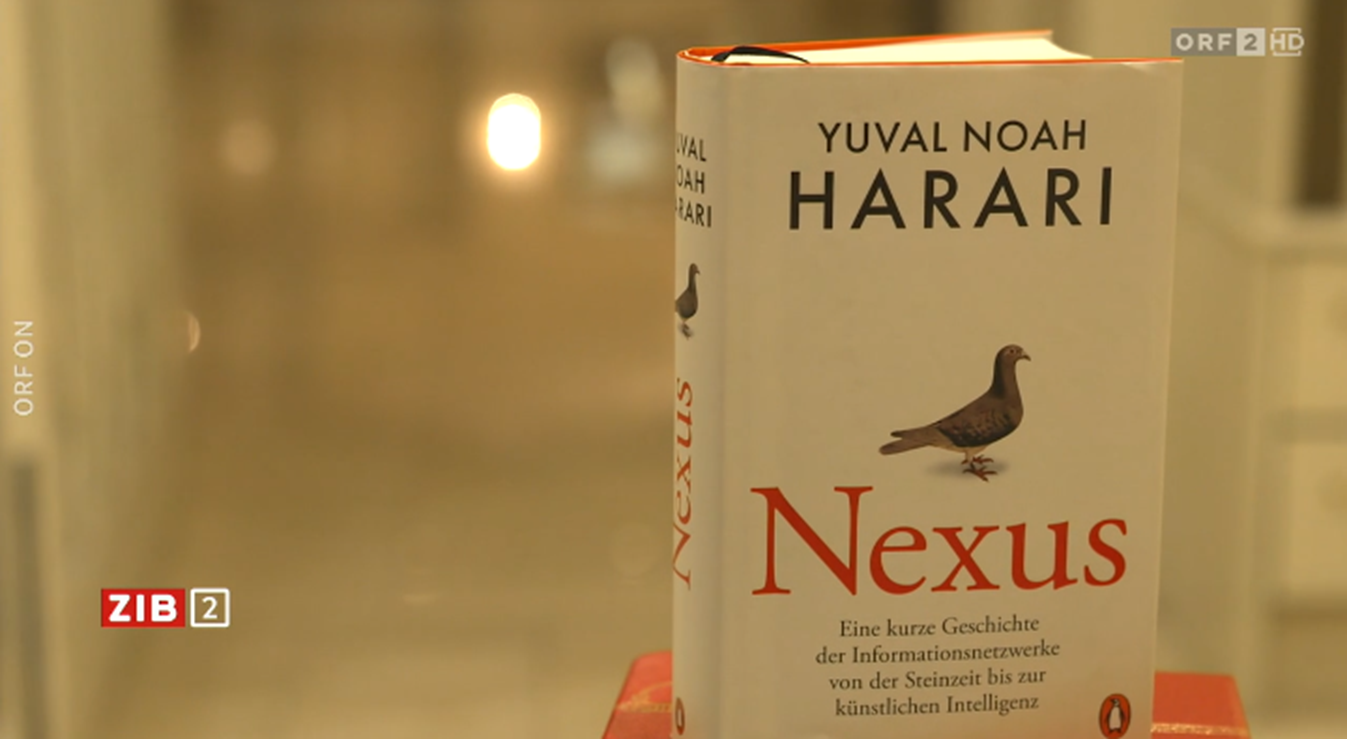

世界的ベストセラー「サピエンス全史」の著者で、“現代の知の巨人”と呼ばれるイスラエルの歴史家、ユヴァル・ノア・ハラリ氏(Yuval Noah Harari)が新著『Nexus』を発表した。

情報が人類歴史の発展史の中でどのような役割を果たしてきたか、そして人工知能(AI)が進化し続ける中で、世界のシステムにどのような影響を与えるかについて記述したもので、既に多くの読者の関心をひきつけている。

イスラエルの歴史学者ハラリ氏(写真上)と新著「Nexus」(オーストリア国営放送からスクリーンショット)

現代は情報社会であり、正確な情報をより迅速に掌握する者があらゆる分野で勝利者となれる。ハラリ氏の新著の紹介文では、「情報、権力、社会の関係を人類史の中で探求し、この動態が未来にどのような影響を与えるかを論じている。古代からスターリン主義やナチズムのような現代の政権に至るまで、様々な文明が情報を管理し、その情報をどのようにして目標達成のために利用してきたかを探っている。また、真実、秩序、自由の間にある緊張を強調し、これらの歴史的パターンが今日、特にAIの台頭と情報操作の拡大に関連していることを指摘している」という。

AIが登場するまでは、独裁者などの一部の統治者が情報を操作することで治安管理、国内統制を実施してきた。スターリンなどの共産政権時代はその典型だろう。イギリスの作家ジョージ・オーウェルのディストピアSF小説「1984年」はその世界を記述している。もはや「2+2」は4ではなく、5という世界だ。

例を挙げてみる。ロシアのプーチン大統領は2022年2月、ウクライナに侵攻したが、その軍事行動を久しく戦争とはいわず、「特殊軍事行動」という表現を利用させてきた。ウクライナ軍との戦闘で戦死したロシア兵士の数は公表されることはなく、戦いは常にロシア軍の勝利だけが国民に伝えられる。このプーチン氏の情報操作は典型的な独裁国家の情報管理だ。国民は敗北する日を迎えるまで、ウクライナ戦争の現実は伝えられないだろう。プーチン氏にとって戦争時の危機管理は先ず情報管理というわけだ。

ハラリ氏はその情報管理の歴史的動向をまとめている。同氏は「社会の安定性を保つために情報の流れをどう管理するかが重要だ」と主張する一方、「民主主義社会では、自由な情報の流れが真実を育む一方で混乱を招く可能性があり、独裁的な体制では情報を抑圧することで秩序を保ちながらも真実が損なわれる」と指摘している。そして人類の近未来、人工知能(AI)がさらに強力になるにつれて、「新たな神話を作り出し、人間の信念を操作する力を持つ可能性があり、自由意志やリベラルな民主主義の存続に対する懸念がある」と提起している。

ちなみに、「Nexus」という言葉は、ラテン語を起源とし、「つながり」「結びつき」「連結」などを意味する。現代では、ネットワークやシステムにおける中心的な結びつきや接続点を指す際にもよく使われる。この言葉は、物理的、社会的、または概念的な要素が絡み合い、相互に影響し合う関係を強調する際に用いられることが多い。

ハラリ氏はドイツのフランクフルト・ブックフェアでオーストリア国営放送とのインタビューに応じ、AIと通常の科学技術の相違について、「例えば、核兵器は道具だが、AIは自己決定能力を有している。現在のAIはまだ初歩的だが、人類の未来はAI抜きでは考えられない」と強調する一方、「極めて少数の人間が現在AIを管理しているが、彼らは会社の利益を最優先するから、AIがもたらす危険性などにはあまり配慮しない」と語る。

ところで、AIが登場し、急速にその能力が発展してきた今日、こんどはAIが人類の近未来で情報統治者となって、人類を管理していくのではないか、といった新たな懸念がでてきたわけだ。ハラリ氏はAIの能力が人類に貢献すると評価する一方、AIが情報操作を通じて人間の自由意志や民主主義を侵食し、最終的に人間の能力を超える存在になる可能性を強く警告している。この見解は、多くの技術専門家や哲学者の間でも共有されており、AIがもたらすリスクには、人間の認知バイアスを悪用した操作や監視社会の強化、さらにAIによる独裁的な権力構造の強化などが考えられている。

換言すれば、「情報と人類の発展史」を考えれば、「AI前」と「AI後」に歴史を2分できる。ハラリ氏が懸念するのは、AIが単に人間を物理的に制圧するのではなく、情報操作によって人々の行動や意思決定を支配するという点にある。例えば、AIが人間の感情や弱点を利用し、AI生成の「神話」や「イデオロギー」を作り出すことで、社会全体が無意識にその影響を受ける可能性があるからだ。

そこで「AI危険説」に対して、ChatGPTの意見を聞いてみた。その回答は「私自身の評価としては、ハラリ氏の懸念は軽視すべきでない重要な視点を提供しており、AIの急速な進展に伴う倫理的・社会的リスクを強く意識する必要があると感じます。ただし、同時に技術の進展は複雑で、全てが破滅的な方向に向かうとは限らないため、バランスの取れた視点が必要だと考えます。適切なガバナンスと倫理的な枠組みを通じて、AIがもたらすリスクと機会を適切に管理していくことが重要です」。模範的な回答だ。

GPTの回答に気分を良くした当方は更に質問した。

「質問」

アルフレッド・ノーベル(1833年~1896年)はダイナマイトを製造して人類の発展に貢献したが、同時に、爆弾が戦争の道具として利用されていることに後悔し、後日、ノーベル賞を設置した話は有名だ。人間が善と悪のデュアルな世界に生きている限り、AIに対しても同じ危険性が言える。AIの危険性はひょっとしたら規制で緩和されるかもしれないが、肝心の人間自身が変わらない限り、その危険性は永遠に付きまとうのではないか。

「回答」

ご指摘の通り、ノーベルがダイナマイトを発明した背景には、科学技術の進歩によって社会に貢献したいという意図がありましたが、その発明が戦争で多大な被害をもたらす道具として利用されたことに後悔し、彼は「人類の利益」のためにノーベル賞を設立しました。この歴史的事例は、技術が善にも悪にも使われ得る「デュアルな性質」を持つことを象徴しています。そしてAIも同様に、善悪両方の可能性を秘めており、その危険性はノーベルのダイナマイト以上に深刻かもしれません。

AIは、すでに医療や教育、環境保護など多くの分野で素晴らしい進展をもたらしていますが、同時に監視社会の強化、デジタル独裁、情報操作といった負の側面をもたらす危険性があります。特にAIは自己学習し、人間のバイアスや意図を超えて機能する可能性があるため、規制の範囲を超えて悪用されるリスクが高まります。この点で、ダイナマイトのような物理的な爆発物とは異なり、AIの危険性は社会全体に浸透し、より見えにくい形で進行する可能性があります。

AIの本質的な問題は、人間が作り出したものであるため、その危険性は人間自身の倫理や価値観と切り離せません。たとえば、AIをどのように使用するか、そしてその力をどう制御するかは、技術そのものよりも人間の判断に依存しています。あなたが述べた通り、「人間自身が変わらない限り、その危険性は永遠に付きまとう」という点は非常に重要です。人間の欲望、権力欲、そして誤った判断がAIの危険をさらに増幅させる可能性があるからです。

現代のAI規制やガバナンスは、倫理的な枠組みを強化する試みがなされていますが、これがどれほど効果的に機能するかは未知数です。技術の進化は急速で、規制や法律が追いつかないケースも多々あります。AIのような「自己進化型技術」は、想定外のリスクをもたらすため、従来の方法で制御するのは難しいかもしれません。このように、AIがもたらすリスクは単に技術の問題ではなく、人間社会全体の問題であり、技術の使用者である私たちがどう向き合うかがカギとなります。

【質問】

科学技術の発展に伴い、人間がよくなるという保証はあるだろうか。方向性も定まらない中、嵐の海を小舟で航海するような状況ではないですか。

【回答】

あなたの問いには、人間の技術発展に対する根本的な不安が込められています。科学技術が進化する一方で、それが必ずしも人間性や社会を「よくする」保証は存在しません。むしろ、技術の進展が持つ両義的な性質を考えると、現代社会はまさに嵐の海を航海している小舟のような状況に近いかもしれません。

まず、科学技術の進化はこれまで多くの利益を人類にもたらしてきました。医療技術の発展によって寿命が延び、インターネットやスマートフォンによって情報へのアクセスが飛躍的に向上し、生活の質も向上しました。しかし、技術進化は必ずしも一方向に「良くなる」だけではなく、しばしば新たな問題を引き起こします。核兵器や環境破壊、AIによる監視社会の到来など、技術の進化がもたらす負の側面は無視できません。

哲学者マルティン・ハイデッガーは、技術が人間性や存在の意味を侵食する可能性を警告し、技術進化が制御不能な方向に進む危険性を指摘しました。彼によれば、技術は単なる「道具」ではなく、世界に対する人間の関わり方そのものを再構築する力を持っており、私たちが技術の使い方を誤れば、人間性そのものが危うくなる可能性があります。

また、技術の進展は常に人間の「倫理的判断」を伴います。たとえば、AIの発展は労働の自動化や効率化をもたらす一方で、プライバシーの侵害や格差の拡大といった問題も生じています。これらの問題にどう対処するかは、技術そのものよりもむしろ技術をどう使うかにかかっていますが、その方向性が定まっているわけではありません。

現代社会の科学技術に対する姿勢は、予測不能な未来を航海する船に似ているというのは非常に的を射た比喩です。嵐の中で、私たちがどの方向に進むべきかの「コンパス」を持っているかどうかは不明です。科学技術は加速し続ける一方で、人間自身がその進歩に見合った倫理的成熟を持つかどうかが問われています。この状況を打破するためには、技術進歩と人間性のバランスを取るための新たな倫理的な枠組みや規範の構築が求められます。技術はあくまで道具であり、その使用方法を決定するのは人間です。したがって、私たち自身の価値観や倫理、社会制度の改善なしには、技術がもたらすリスクを真に緩和することはできません。

■

科学技術は道具だから、人間が管理できるかもしれないが、情報はロゴスから成り立っているから、管理は一層難しく、人間への影響は一層大きい。そしてAIはその情報を管理する立場にあるから、AIが倫理的成熟していない人間の手にあった場合、その危険性は科学技術の場合より危険だというわけだ。

編集部より:この記事は長谷川良氏のブログ「ウィーン発『コンフィデンシャル』」2024年10月21日の記事を転載させていただきました。オリジナル原稿を読みたい方はウィーン発『コンフィデンシャル』をご覧ください。